Apple, geçtiğimiz günlerde yeni bir özelliği yürürlüğe koyacağını duyurdu: Çocuk cinsel taciz materyali (Child Sexual Abuse Material - CSAM) tespit özelliği. Yani kullanıcı fotoğraflarını çocuk istismarına karşı kontrol etmek için iCloud'a yüklenen fotoğrafları otomatik olarak taramak. Şirket bunu, çocuk istismarı ile ilgili içerikleri sınırlamak için yapıyor, ancak aynı zamanda "çocukları, işe almak ve sömürmek için iletişim araçlarını kullananlardan korumak" için başka özellikler de ekliyor. Yeni özellikler şimdilik, yalnızca ABD'de devrede olacak.

CSAM Tespit Özelliği Nedir?

Konuyu biraz açalım: Apple, iOS 15 ve iPadOS 15'te, önceden tanımlanmış CSAM içeriğiyle eşleşip eşleşmediklerini görmek için bir kullanıcının cihazından iCloud'a yüklenen görüntüleri otomatik olarak tarayacak yeni bir özellik sunuyor.

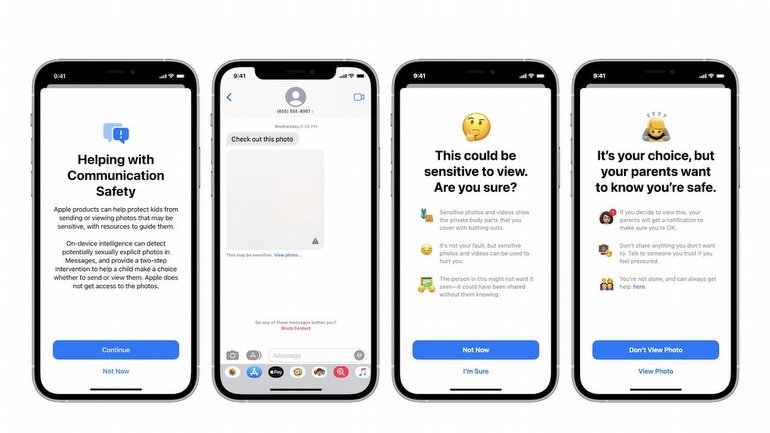

Dijital parmak izlerini kontrol etmek, web sitesi güvenlik şirketi CloudFare'in 2019'da kurduğu ve Ashton Kutcher ve Demi Moore tarafından ortaklaşa kurulan çocuk seks kaçakçılığı karşıtı kar amacı gütmeyen Thorn tarafından da kullanılan CSAM'i tespit etmek için yaygın bir yöntem. Buna ek olarak Apple, ebeveynlerin aile ağlarındaki çocuklar için isteğe bağlı olarak etkinleştirebilecekleri bir sistem daha sunuyor: Gelen ve giden fotoğrafları cinsel içerikli olabilecek ve varsayılan olarak bulanıklaştırılacak materyaller için tarayan Mesajlar uygulamasındaki cihaz analizi. Bu sistem, isteğe bağlı olarak, içeriğin görüntülenmesi durumunda hesaba bağlı ebeveynleri bilgilendirmeyi amaçlıyor.

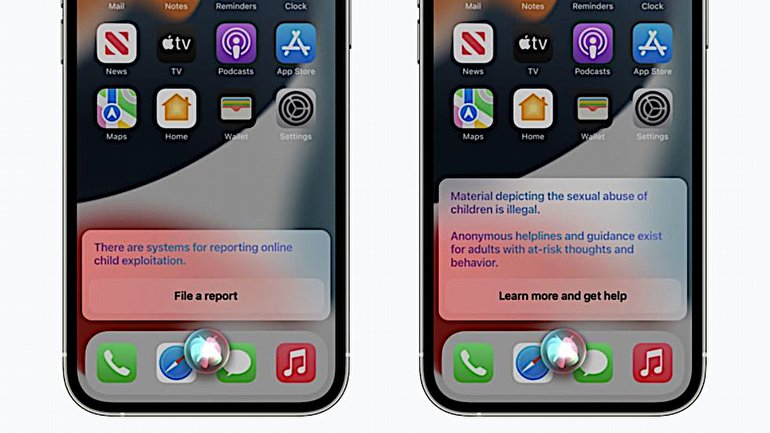

Apple ayrıca, bir kullanıcı CSAM'i bildirmekle ilgili soru sorarsa, Siri ve Arama'nın yararlı kaynakları ortaya çıkarmasını sağlıyor; her ikisi de kullanıcılar CSAM ile ilgili sorguları aradığında devreye girerek, materyalin zararlı potansiyeli hakkında bilgilendirme sunuyor ve yardım almak için kaynaklara yönlendiriyor.

Tüm bunlar, Apple'ın kendi açıklamasına göre, CSAM'i izlemek için yazılımı nasıl entegre edeceğine ve olası uygunsuz fotoğrafları aldıklarında (ve gönderdiklerinde) müdahale ederek çocukları korumaya nasıl yardımcı olacağına dair temel hatları oluşturuyor. Ancak Apple'ın bir kullanıcının aldığı ya da gönderdiği içeriği otomatik olarak tarama olasılığı, teknoloji uzmanlarının ve gizlilik savunucularının endişelerini de beraberinde getiriyor.

Bu Özellik Beni Etkiler mi?

CSAM ile ilgili bir Siri sorgulaması veya çevrimiçi arama yapmazsanız, ya da iCloud hesabınızda şüpheli bir içerek yoksa sizin için hiçbir şey değişmeyecek. iPhone veya iPad'inizin hesabı iCloud'da bir aile ile ilişkiliyse ve cihazınız bu ağda bir çocuk olarak belirlenmişse, müstehcen fotoğraflar aldığınızda uyarılar ve bulanık fotoğraflar göreceksiniz. Cihazınız bir çocuğa ait olarak bir aile ağına bağlı değilse, sizin için yine hiçbir şey değişmeyecek.

Son olarak, iOS 15, iPadOS 15 veya macOS Monterey'e yükseltme yapmazsanız cihazınız bu özelliklerden hiçbirini almayacak.

Bu uygulama şu an için sadece ABD'deki kullanıcılara sunuluyor. Ancak Apple'ın başka ülkelerde de CSAM özelliğini sunacağına kesin gözüyle bakabiliriz.

Apple Bunu Neden Yapıyor?

Ahlaki bir bakış açısıyla Apple, CSAM'ı engelleyerek ebeveynlere, çocuklarını korumaları için güçlü bir yol sunuyor. Şirketin blog yazısında belirttiği gibi, "bu programın amacı, çocukları korumak."

Apple, cihazlarının gizlilik özelliklerini hiç bıkmadan vurgulayan bir şirket. Güvenli uçtan uca şifreli iletişimler gibi önlemler sık sık ön plana çıkartılıyor, iOS 14.5'te kullanıma sunulan Uygulama İzleme Takibi gibi özellikler geliştiriliyor. Ancak aynı Apple, yıllar boyunca, görünüşte şirketi daha fazla gizlilik korumasına iten birçok davanın da başrol oyuncusu oldu.

Güvenlik Araştırmacıları Ne Diyor?

Apple yeni özelliğini duyurduktan kısa bir süre sonra, güvenlik uzmanları ve gizlilik savunucuları doğal olarak alarma geçti. Apple'ın bahsi geçen içerikleri kullanıcı hesaplarında tespit etme yöntemleriyle ilgili endişeler dile getirilmeye başlandı.

CSAM tarama özelliği isteğe bağlı gibi görünmüyor - varsayılan olarak iOS 15'e dahil edilecek ve indirildikten sonra işletim sisteminden kapatılamayacak. Tek yol, iCloud'u kapatmak olacak. Bir iCloud hesabına yüklenmeden önce bir kullanıcının cihazındaki fotoğraflar otomatik olarak taranacak. Tarama sırasında belirli bir fotoğraf CSAM örnekleri ile eşleşirse, Apple bu görüntüyü manuel olarak inceleyecek ve eğer şüphe doğru çıkarsa, kullanıcının hesabı kapatılacak; bilgileri kolluk kuvvetleriyle işbirliği yapan Ulusal Kayıp ve İstismara Uğramış Çocuklar Merkezi'ne (NCMEC) iletilecek.

Apple, kullanıcı verilerini şifreli ve şirket çalışanları tarafından okunamaz halde tutmak için çok dikkatli davrandığını söylüyor. Ve Apple'a göre sistem, "son derece yüksek bir doğruluk düzeyi sağlayacak şekilde ayarlanmış; belirli bir hesabın yanlış bir şekilde işaretlenmesi için yılda bir trilyonda birden daha az ihtimal bulunuyor."

Yine de gizlilik savunucularının eli, otomatik tarama nedeniyle oldukça güçlü sayılabilir. Dijital gizlilik konusunda kar amacı gütmeyen bir kuruluş olan Electronic Frontier Foundation (EFF), Apple'ın girişimine karşı yayınladığı blog yazısında, "Arka kapı her zaman bir arka kapıdır" diye yazdı ve bu otomatik tarama teknolojisini eklemenin bile potansiyel olarak daha geniş erişim suistimallerine kapı açtığını belirtti. Yazıda şu sözler dikkat çekiyor: "Apple'ın oluşturduğu dar arka kapıyı genişletmek için gereken tek şey, ek içerik türlerini aramak için makine öğrenimi parametrelerinin genişletilmesi veya yalnızca çocukların değil, herkesin hesaplarının taranması için yapılandırma bayraklarında ince ayar yapılmasıdır."

Teknoloji endüstrisindeki diğer dev şirketler de Apple'a tepki gösteriyor. Facebook'un sahip olduğu WhatsApp'ın başkanı Will Cathcart da dahil olmak üzere pek çok önemli isim, Apple'ın otomatik tarama girişimine karşı tepkilerini açıkça ortaya koyuyor.

Bazı teknoloji uzmanları ise, EFF'nin görüşüne tamamen katılmadan önce Apple'ın daha fazla bilgi vermesini bekliyor. Techsponential adlı teknoloji araştırma ve analiz firmasının kurucusu Avi Greengart, Twitter mesajında endişelerin korkutucu derecede yerinde veya aşırı tepki olabileceğini söylüyor ve Apple'ın daha fazla ayrıntı sağlaması gerektiğinin altını çiziyor. Ama CSAM özelliğine çok da uzak görünmüyor: "Bir ebeveyn olarak, iMessage'ın göndermeden önce reşit olmayanların cinsel mesajlarını işaretleyeceği fikrini seviyorum; süreci geçici olarak yavaşlatan ve çocuklara sonuçları hakkında düşünme şansı veren her şey iyi bir şeydir."